Am 3. Dezember habe ich für weiterbildung.berlin ein kurzes Webinar zum Thema „KI & Ethik“ gehalten. Hier nun eine eine kleine Zusammenfassung :

Der uralte Traum vom künstlichen Menschen

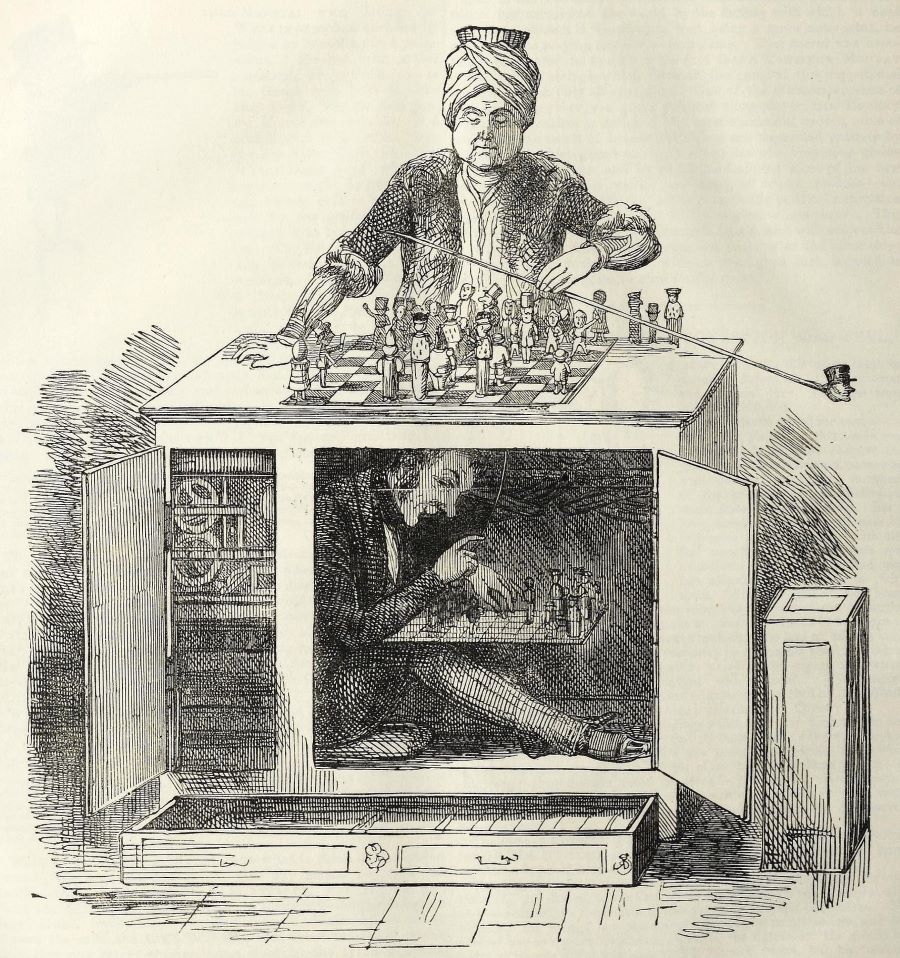

Es gibt Geschichten, die uns lange begleiten, bevor wir sie verstanden haben. Eine davon ist die vom Schachtürken, diesem barocken Automaten, der angeblich Schach spielte wie ein Genie. Die Leute staunten, Könige staunten, sogar Napoleon ließ sich angeblich von ihm besiegen. Erst viel später stellte sich heraus, dass im Inneren ein menschlicher Meister hockte, verborgen und schwitzend. Doch die Maschine war nie klüger als der Mensch, der in ihr saß. Sie war nur überzeugender.

Wer über KI und Ethik spricht, beginnt am besten genau hier: bei der Faszination für das scheinbar Denkende, das am Ende doch nur ein Spiegel ist.

Der Wunsch, etwas Menschliches in etwas Nichtmenschliches zu übertragen, ist älter als jedes Rechenzentrum. In Prag erschuf der Rabbi Löw den Golem aus Lehm, der die Menschen schützen sollte. Er war keine Maschine im modernen Sinne, sondern ein Projektionsraum. Ein Wesen ohne Seele, das dennoch menschliche Hoffnungen und Ängste verkörperte. Seine Stärke war beeindruckend, seine Unberechenbarkeit gefürchtet. Doch gefährlich war nicht der Golem, sondern der Mensch, der ihn erschaffte.

Auch die Popkultur hat diese Figuren immer wieder benutzt, um unsere eigenen moralischen Grenzen lesbar zu machen. In Metropolis führte der Maschinenmensch Maria die Menschen in eine Revolte, weil sie nicht mehr unterscheiden konnten, was echt und was nachgeahmt war. In Blade Runner stellte der Replikant Roy Batty die unbequeme Frage nach Würde und Leben, kurz bevor er starb. Und in Ex Machina zeigte die künstliche Ava, wie leicht sich Menschen täuschen lassen, wenn sie etwas sehen wollen, das nicht da ist. Diese Erzählungen prägen unser Bild von KI stärker als jede technische Erklärung. Und sie bereiten das Feld für eine Frage, die nicht trivial ist: Was sehen wir, wenn wir eine Maschine sprechen hören?

Was wir meinen, wenn wir über Ethik reden

Ethik klingt nach Normen, nach Regeln und nach akademischen Seminartischen. Doch die klassische Ethik war immer praktisch gdacht. Aristoteles bestand darauf, dass ethisches Handeln etwas ist, das man tut, nicht etwas, das man weiß. Sein Gedanke, dass wir das sind, was wir wiederholt tun, passt erstaunlich gut in unsere Gegenwart. Es geht nicht um eine perfekte moralische Theorie, sondern um die kleine Frage: Wie treffen wir gute Entscheidungen, wenn Technik diese vorstrukturiert?

Kant formulierte einen etwas schärferen Ansatz, als er schrieb, man dürfe Menschen niemals nur als Mittel benutzen. Diese Setzung ist unbequem, besonders in einer Zeit, in der Daten zu Rohstoffen werden und Aufmerksamkeit zur Währung. Wer KI entwickelt, trainiert oder nutzt, kommt an dieser Frage nicht vorbei. Denn KI ist gebaut aus den Daten anderer Menschen. Sie wird gespeist von Sprache, Bildern, Situationen und Bewertungen, die Menschen produziert haben. Und genau deshalb darf sie uns nicht in Versuchung führen, uns aus der Verantwortung zu flüchten.

Nutzen wir daher die folgende Definition als Grundlage für die weiteren Betrachtungen:

Gute Handlungen und gute Systeme sind diejenigen, die die Würde aller achten, ihre realen Fähigkeiten zum Leben in Freiheit, Gesundheit und Teilhabe stärken und deren Regeln in einem fairen, offenen Diskurs begründet werden können.

Ethik im Kontext von KI heißt daher eben nicht, die Maschine moralisch zu machen. Das wäre ein Kategorienfehler. Maschinen haben kein Innenleben. Sie haben Muster. Was wir aber moralisch gestalten können, sind die Rahmenbedingungen: Wer macht sich zunutze, was andere beigetragen haben? Welche Verantwortung entsteht daraus? Und wie verhindern wir, dass Entscheidungen, die Menschen betreffen, plötzlich wie technische Prozesse wirken, obwohl sie in Wahrheit menschlich bleiben sollten?

Was künstlich ist, ist selten maschinell

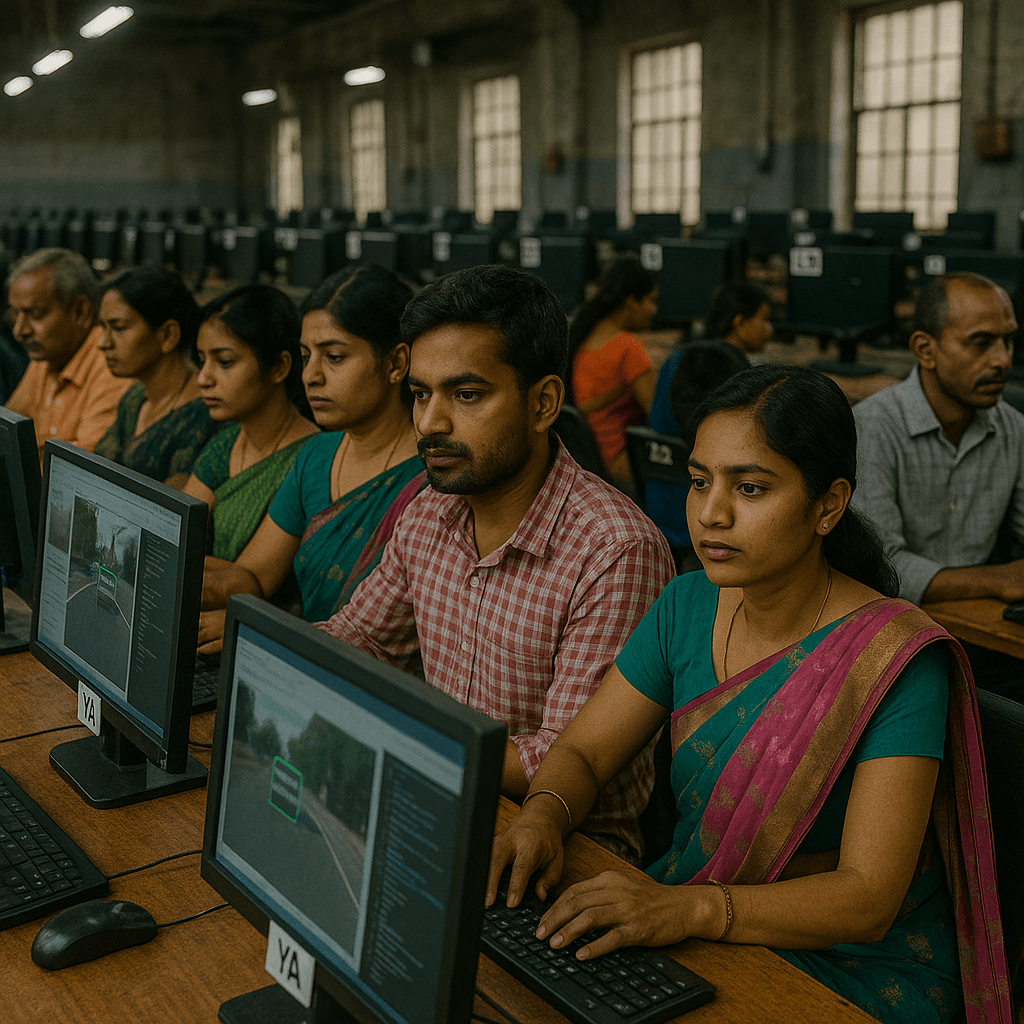

Das Wort künstlich wird oft so verwendet, als würde es eine klare Grenze markieren. Hier der Mensch, dort die Maschine. Doch wer genauer hinsieht, erkennt, wie viel Mensch in jeder KI steckt. So beschäftigt Meta beispielsweise über 40.000 Content-Moderatoren, meist im globalen Süden, um KI-Ausgaben zu „säubern“. Sie bekommen durchschnittlich 1,78 USD pro Stunde, um Gewalt, Missbrauch und Traumainhalte für KI-Modelle zu kennzeichnen. damit die KI sie später nicht reproduziert. Viele leiden bedingt durch diese Arbeit selbst unter Traumatisierung, nur damit „unsere“ KI höflich klingt.

Der Tech-Ethiker Timnit Gebru hat diesen Umstand einmal wie folgt zusammengefasst: Es handelt sich hier nicht künstliche Intelligenz, sondern um verwaltete menschliche Arbeit im industriellen Maßstab. Wir automatisieren nicht Intelligenz, wir skalieren menschliche Vorarbeit.

Ethik beginnt daher nicht bei der Ausgabe der KI, sondern bei ihrer Entstehung.

Das Start-up Builder.ai, das zwischenzeitlich mit anderthalb Milliarden Dollar bewertet war, versprach beispielsweise eine KI, die eigenständig Programmcodes schreibt – in Wahrheit verrichteten jedoch 700 indische Ingenieure die Arbeit.

Immer wieder bedeutet künstliche Intelligenz also in einem ironischen Twist, dass menschliche Arbeit an Maschinen ausgelagert wird, die wiederum von Menschen gesteuert werden. Spöttisch wird AI schon mit „Actually Indians“ übersetzt.

Auch die Trainingsdaten, die wir gerne als abstrakte Größen betrachten, bestehen aus Millionen menschlicher Spuren. Texte aus Foren, Artikel, Blogeinträge, Bilder aus sozialen Netzwerken. All das wird zu Rohstoff für Modelle, die später mit einer Eleganz formulieren, die fast unheimlich wirkt. Doch diese Eleganz ist kein Bewusstsein. Es ist Statistik. Die Ausgabe eines mathematischen Wahrscheinlichkeitsprozesses. Wer denkt, eine KI würde fühlen, was sie formuliert, verwechselt Sprache mit Empfinden.

Genau hier liegt die zentrale Verwirrung unserer Zeit. KI klingt menschlich, aber sie versteht nichts. Sie kann Trauer erklären, ohne traurig zu sein. Sie kann Entscheidungen imitieren, ohne Verantwortung zu empfinden. Sie kann Situationen beschreiben, ohne sich in ihnen zu befinden. In der Informatik nennt man das symbolische Manipulation. Der Philosoph Hubert Dreyfus hat dazu einmal gesagt: „Computer verstehen die Welt nicht, sie manipulieren Symbole.“ Der Satz ist über vierzig Jahre alt, aber aktueller denn je.

Warum KI mit einem verzerrten Weltbild spricht – und was das bedeutet

Die meisten Menschen glauben, KI sei neutral. Ein technisches System, das aus allen verfügbaren Informationen etwas abstrahiert, das dann irgendwie objektiv wirkt. Doch Neutralität ist ein Mythos. KI-Modelle lernen aus dem Material, das wir ihnen geben. Und dieses Material stammt überwiegend aus Regionen, die eine kulturelle Dominanz haben. Diese Datenlandschaft ist westlich, männlich und hellhäutig geprägt. Das Weltbild der KI entspricht daher häufig jener Perspektive, die ohnehin schon laut ist.

Die Folgen sind subtil und gleichzeitig folgenreich. Wenn KI Gesichter generiert, erscheinen sie überproportional hell. Wenn KI erklärt, was Führung bedeutet, spart sie jene kulturellen Kontexte aus, in denen Autorität anders funktioniert. Wenn KI Geschichten schreibt, kopiert sie Narrative, die seit Jahrzehnten aus privilegierten Perspektiven erzählt werden. Gesichtserkennungssysteme scheitern bei dunklerer Haut, nicht weil die Technik schlecht wäre, sondern weil die Daten blind sind.

Bias entsteht auch durch Abwesenheit. KI kennt Hunger als Begriff, aber nicht als Erfahrung. KI kennt Migration als Schlagwort, aber nicht als biografische Zäsur. KI kennt Diskriminierung als statistisches Muster, aber nicht als Verletzung. Die Maschine ist unbeteiligt, und Unbeteiltheit wird zur Gefahr, sobald Systeme Entscheidungen vorbereiten, die Menschen betreffen. Ein verzerrtes Weltbild produziert verzerrte Vorschläge, und diese Vorschläge wirken oft neutral, obwohl sie aus einer Schieflage stammen.

Unter ehtischen Gesichtspunkten betrachtet bedeutet das, dass KI bestehende Machtverhältnisse verstärkt. Sie macht jene sichtbarer, die ohnehin sichtbar waren. Sie schreibt Normen fort, die nie universell waren. Und sie tut es mit einer Selbstverständlichkeit, die technischer Objektivität ähnelt, aber eine kulturelle Einseitigkeit verbirgt. Die Frage nach gerechter KI ist deshalb nicht technisch. Sie ist moralisch. Es geht darum, wer im Datenkorpus vorkommt, wer fehlt und wer von den Ergebnissen betroffen ist. Eine Maschine sieht Muster. Doch wir müssen entscheiden, welche Muster wir korrigieren. Vielfalt wird dadurch zu einem ethischen Imperativ, nicht zu einem technischen Feature.

Warum KI Werte spiegelt, aber keine empfinden kann

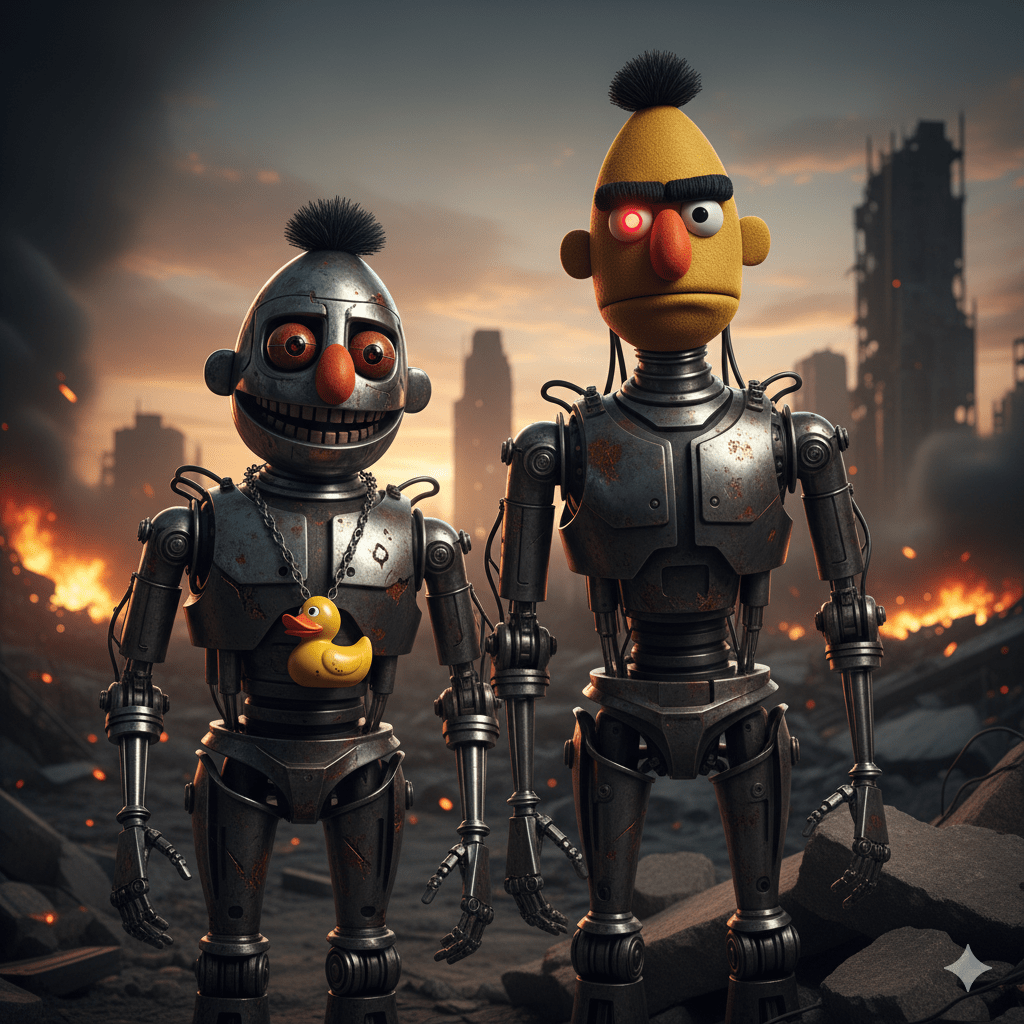

Wenn man Menschen fragt, was KI eigentlich sei, hört man fast immer Bilder: der menschenähnliche Roboter, das unnahbare Metallwesen, manchmal die dystopische Kampfmaschine. Diese Bilder stammen aus Filmen, Mythen und aus unserer Neigung, Technik zu vermenschlichen. Joseph Weizenbaum hat das früh beschrieben: Menschen schreiben Maschinen Gefühle zu, selbst dann, wenn sie wissen, dass es Maschinen sind. Er nannte das den Eliza-Effekt, benannt nach seinem einfachen Chatprogramm aus den 1960ern. Seine Warnung klingt heute erstaunlich prophetisch: Die gefährlichere Grenze sei nicht die der Maschinen, sondern die der Menschen, die ihnen zu viel zutrauen.

KI arbeitet eben mit Wahrscheinlichkeiten, nicht mit Wahrheiten. Das ist kein Fehler, sondern das Funktionsprinzip. Die Maschine setzt Wörter so, wie Menschen sie häufig gesetzt haben. Das Ergebnis wirkt verständig, ist aber errechnet. Die Sprache der Maschine ist nicht die Sprache der Erfahrung. Und das führt zu einer wichtigen Folgerung: Wenn KI Werte ausdrückt, dann sind es unsere Werte, die in den Daten stecken. Wenn KI diskriminiert, sind es unsere Muster, die sich wiederholen.

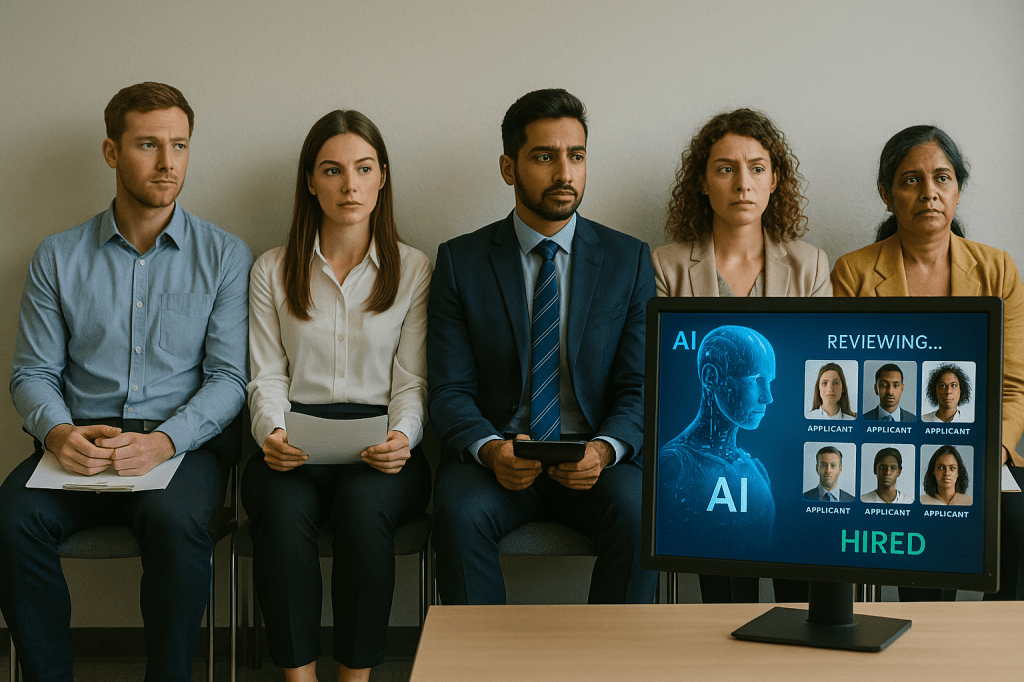

Ethisch entsteht daraus ein Dilemma, das sich nicht technisch lösen lässt. Wenn KI mit einem Weltbild spricht, das privilegiert ist, dann verstärkt sie auch diese Privilegien. Sie gibt jenen mehr Raum, die ohnehin schon mehr Raum hatten. Sie schreibt Normen fort, die nie universell waren. Und sie macht Unterschiede unsichtbar, die gesellschaftlich relevant sind. Wer Entscheidungen automatisiert, automatisiert deshalb auch die blinden Flecken derer, die die Daten produziert haben. Sobald KI Teil von Bewerbungsverfahren, Kreditentscheidungen oder medizinischen Empfehlungen wird, hat Bias reale Konsequenzen. Ein verzerrtes Weltbild produziert verzerrte Ergebnisse. Und wenn diese Ergebnisse später als objektiv gelten, wird Ungerechtigkeit technisch legitimiert.

Denn Technik kann menschliches Verhalten verändern, indem sie Entscheidungen vorstrukturiert. Doch sie ersetzt nicht das moralische Empfinden. Sie kann es einfach nicht, weil sie keins hat. Die Frage, wie wir KI einsetzen, ist deshalb keine Frage an die Maschine. Es ist eine Frage an uns selbst. Eine Art modernes Selbstgespräch: Was ist uns wichtig, wenn Technologie unsere Fähigkeiten erweitert?

Die moralischen Prüfsteine unserer Zeit

Wer über Ethik spricht, kommt an den Ressourcen nicht vorbei. Große KI-Modelle brauchen massive Rechenleistung. Rechenleistung braucht Energie. Energie macht die Frage nach Bequemlichkeit plötzlich moralisch. Google veröffentlichte 2023, dass allein die Entwicklung der großen Modelle so viel Wasser brauchte wie der Verbrauch einer Stadt mit 50.000 Einwohnern..

Eine Abfrage in GPT-4o verbraucht so viel wie eine Energiespar-lampe, die mehrere Minuten leuchtet. Eine Anfrage an die KI Gemini verbraucht 0,24 Wattstunden Strom – laut Google. Das ist etwa so viel, wie eine Mikrowelle in einer Sekunde verbraucht oder entspricht ungefähr dem Energieverbrauch von 8-10 Sekunden Netflix-Streaming entspricht. Dabei würden auch rund fünf Tropfen Wasser verbraucht (0,26 Milliliter). Wasser wird zur Kühlung der Rechenzentren benötigt.

Doch momentan werden rund 30.000 Anfragen pro Sekunde an Gemini gestellt – weltweit. Hochgerechnet werden also allein dafür jeden Tag 622.080 kWh Energie verbraucht:

Zum Vergleich: Ein durchschnittlicher 3-Personen-Haushalt in Deutschland verbraucht etwa 3.500 kWh pro Jahr (Strom, ohne Heizung). 622.080 kWh reichen also für rund 178 Jahre Haushaltsstrom oder für ca. 178 Haushalte jeweils 1 Jahr.

Ein ICE 4 verbraucht rund 20 kWh pro Kilometer. 622.080 kWh reichen für ca. 31.000 ICE-Kilometer. Das sind ca. 50 Fahrten Berlin–München hin und zurück.

Und das betrifft nur Google Gemini. Chat GPT hat nach eigener Angabe über 50.000 Anfragen pro Sekunden, ansteigend.

Der Economist schrieb einmal dazu: KI ist grenzenlos, nur die Ressourcen der Erde nicht. Die Frage, die sich daher anschließt, ist nicht technischer Natur. Sie ist schlicht menschlich: Wie viel Bequemlichkeit ist vertretbar?

Ein weiterer Prüfstein sind die Daten. In ihnen stecken Biografien, Mühen, Verletzlichkeiten, schöpferische Leistungen. Viele Modelle wurden mit Material trainiert, das nie für diesen Zweck vorgesehen war. Tagebucheinträge, Kunstwerke, Musik, Fotos. Jaron Lanier beschrieb Daten einmal als die Schatten, die wir im Netz hinterlassen. KI benutzt diesen Schatten, ohne zu fragen, ob sie überhaupt irgendjemand nutzen darf. Sobald die Maschine kreativ scheint, muss man deshalb fragen: Wessen Kreativität ist das?

Und schließlich geht es um die Verantwortung. KI hilft beim Auswählen von Bewerbern, beim Schreiben von Texten, beim Diagnostizieren von Mustern. Doch weder haftet sie für Fehler, noch kann sie Reue empfinden. Papst Franziskus formulierte 2024 eindringlich: Kein Algorithmus darf über das Schicksal eines Menschen entscheiden. Dieser Satz lässt sich über jede Branche legen, vom Marketing bis zur Medizin. Er beschreibt die Grundhaltung einer Ethik, die sich daran orientiert, dass Technik niemals die letzte Instanz sein darf.

Wenn eine KI falsche Fakten liefert oder Narrative verstärkt, ist das System nicht die verantwortliche Instanz. Es ist derjenige verantwortlich, der diese Inhalte nutzt, veröffentlicht oder weitergibt. Wir können die Urheberschaft automatisieren, aber nicht die Verantwortung.

Was ich als einzelner Mensch tun kann

Ethisch mit KI umzugehen heißt nicht, perfekt zu sein. Es heißt, sich nicht blind treiben zu lassen. Der erste Schritt ist oft sehr unspektakulär: einen Moment länger nachdenken, bevor man auf „Generate“ klickt. Nicht, weil KI verboten wäre, sondern weil es einen Unterschied macht, ob ich sie bewusst nutze oder gedankenlos. Wenn ich eine Aufgabe an die Maschine abgebe, kann ich mich fragen: Will ich hier wirklich meine Urteilskraft delegieren, oder möchte ich sie nur unterstützen lassen? Allein diese kleine Frage schärft den inneren Kompass. Ethik beginnt damit, dass ich nicht so tue, als wäre die Maschine klüger als ich.

Ein zweiter Schritt besteht darin, sich die Herkunft der Maschine bewusst zu machen. Ich kann mir angewöhnen, bei jedem Modell, das ich nutze, einmal nachzulesen, womit es trainiert wurde, wer dahinter steht, welche Geschäftsmodelle dahinter liegen. Das klingt trocken, ist aber eine Form von digitaler Achtsamkeit. Je besser ich verstehe, auf welchem Fundament meine Werkzeuge stehen, desto klarer kann ich entscheiden, wo ihre Grenzen sind. Aus Konsum wird dann eine Art Partnerschaft auf Zeit, keine stille Abhängigkeit.

Im Alltag hilft es, KI nicht nur als Schreibmaschine mit Turbolader zu sehen, sondern als Spiegel für die eigenen Werte. Ich kann bewusst nach Perspektiven fragen, die im Standardbetrieb untergehen. Wenn ich mir Texte generieren lasse, kann ich die Maschine auffordern, Stimmen aus dem globalen Süden einzubringen, weibliche Erfahrung sichtbarer zu machen oder marginalisierte Positionen ernsthaft zu berücksichtigen. Ich zwinge die Maschine damit dazu, sich zu strecken. Und ich trainiere gleichzeitig meinen eigenen Blick, nicht nur die bequemste Perspektive zu wählen.

Ethisches Verhalten zeigt sich auch in den Daten, die ich selbst in die Maschine hineingebe. Muss jede vertrauliche Mail wirklich durch ein externes System laufen, nur damit sie schöner klingt? Muss jedes Bild, auf dem andere zu sehen sind, ohne Rückfrage durch Bildmodelle gejagt werden? In dem Moment, in dem ich beginne, bewusst Nein zu sagen, entsteht so etwas wie ein persönlicher Kodex. Kein kompliziertes Regelwerk, eher eine innere Faustregel: Ich muss mich fragen, ob ich das, was ich über Menschen mitteile, auch in einem Raum voller anderer Menschen äußern würde. Wenn die Antwort nein ist, hat der Prompt zumindest eine Pause verdient.

Hinter jedem Datensatz steht ein Leben. Wenn ich Daten respektlos behandle, behandle ich Menschen respektlos.

Welche Spielregeln wir als Gesellschaft brauchen

Als Gesellschaft können wir nicht darauf hoffen, dass sich das Problem von selbst sortiert. Wer die Infrastruktur für KI baut, hat andere Zielkonflikte als diejenigen, die später mit den Folgen leben müssen. Deshalb brauchen wir Spielregeln, die mehr sind als technische Standards. Es braucht so etwas wie einen Verfassungstext für die digitale Sphäre, der klar macht, was wir einem Algorithmus zutrauen und was nicht. Der EU AI Act ist ein erster Versuch, so etwas zu formulieren. Entscheidend ist, dass diese Regeln nicht im Maschinenraum der Konzerne stecken bleiben, sondern in der Öffentlichkeit diskutiert werden.

Ein zentraler Baustein solcher Spielregeln ist Transparenz. Menschen müssen erkennen können, wann sie mit einer Maschine interagieren, wie Entscheidungen vorbereitet wurden und auf welcher Datenbasis Empfehlungen entstehen. Inhalte, die von KI erzeugt oder stark bearbeitet wurden, sollten gekennzeichnet sein, nicht um sie zu stigmatisieren, sondern um einordnen zu können, wie sie entstanden sind. Das gilt für Kreditvergaben ebenso wie für Schulen, Verwaltungen oder Krankenhäuser. Bei automatisierten Entscheidungen muss klar sein, ob ein Algorithmus beteiligt ist, nach welchen Kriterien er arbeitet und wer ihn verantwortet: Kein geheimer Algorithmus in Fragen, die Leben, Freiheit oder Würde betreffen. Wer sich hinter einem System versteckt, entzieht sich der Verantwortung. Deshalb sollte es verbindlich sein, dass dort, wo KI erheblichen Einfluss auf Lebenswege hat, auch erklärt werden muss, wie sie eingesetzt wird. Nicht im technischen Detail, aber so, dass Laien eine Chance haben zu verstehen, was mit ihnen geschieht.

Bildung ist die zweite große Baustelle. Ethisch sensible KI lässt sich nicht verordnen, wenn Menschen nicht gelernt haben, Fragen zu stellen. Schulen, Hochschulen und Weiterbildungseinrichtungen sollten nicht nur die Nutzung von KI vermitteln, sondern auch ihre Grenzen, ihre Bias, ihre Blindstellen. Es reicht nicht, zu erklären, wie man bessere Prompts schreibt. Es muss auch darum gehen, wie man bessere Fragen stellt: Wer fehlt in diesen Daten? Wer trägt das Risiko? Wie könnte eine alternative Lösung aussehen, die nicht alles automatisiert? Eine Gesellschaft, die solche Fragen nicht trainiert, wird leicht formbar für technische Lösungen, die vor allem eines tun: Macht konzentrieren.

Schließlich braucht es Institutionen, die nicht nur die Technik prüfen, sondern die Folgen. Ethikräte, Aufsichtsbehörden, zivilgesellschaftliche Organisationen – sie alle sollten mitreden, wenn über den Einsatz von KI in sensiblen Bereichen entschieden wird. Es reicht nicht, ein Gremium hinzustellen und damit das Gewissen zu beruhigen. Es geht darum, die Stimmen derjenigen einzuholen, die von Entscheidungen betroffen sind, aber keine eigene Lobby haben. Ethik entsteht dort, wo Sichtbarkeit nicht den Zufall braucht, sondern eingeplant ist.

Wenn wir all das ernst nehmen, entsteht langsam ein anderes Bild von KI. Nicht mehr das des allmächtigen Systems, das uns ersetzt, sondern das eines mächtigen Werkzeugs, das unsere bestehenden Strukturen verstärkt. Dann wird die entscheidende Frage nicht mehr lauten, ob KI gut oder böse ist. Sie wird lauten, ob wir bereit sind, unsere Spielregeln so zu gestalten, dass Technik das Beste in uns unterstützt, statt das Schlechteste zu vergrößern. Ethik und KI werden dann keine Gegensätze sein, sondern ein Verhältnis, das wir aktiv gestalten müssen. Genau darin liegt die eigentliche Zumutung – und die Chance.

Was die Maschine aus uns macht

Am Ende führt jede Diskussion über KI zu einer anthropologischen Frage. Wen sehen wir im Spiegel, wenn wir der Maschine zuhören? Technik beeinflusst nicht nur, wie wir arbeiten, sondern auch, wie wir uns selbst verstehen. KI zwingt uns, genauer hinzusehen. Sie verlangt, dass wir erklären, was Verantwortung, Kreativität, Entscheidungskraft und Würde für uns bedeuten. Sie nimmt uns nichts ab, was wir nicht freiwillig abgeben. Und genau darin liegt ihre paradoxe moralische Kraft: Sie macht uns nicht unmenschlich, sie erinnert uns daran, dass unser Menschsein nicht selbstverständlich ist.

Vielleicht lässt sich der gesamte Diskurs auf einen Satz bringen, der erstaunlich unspektakulär klingt: Die Maschine denkt nicht, aber sie zwingt uns zum Denken. Ein Satz, der eine Herausforderung enthält. Denn Denken heißt nicht nur verstehen, sondern auch entscheiden. Und Entscheiden heißt Verantwortung tragen. KI mag vieles beschleunigen, vieles vereinfachen, vieles eleganter aussehen lassen. Doch der Kern bleibt menschlich. Und deshalb führt jede gute KI-Debatte zurück zu uns selbst.

Die Frage ist nicht, ob KI menschlich wird.

Die Frage ist, ob wir es bleiben.

Hinterlasse einen Kommentar